Testez VOTRE Entreprise en Minutes

Créez votre compte et lancez votre chatbot IA en quelques minutes. Entièrement personnalisable, aucun codage requis - commencez à engager vos clients instantanément!

Comprendre l'écart contextuel

La compréhension du contexte représente l'un des défis les plus importants du développement de l'intelligence artificielle. Contrairement aux humains, qui interprètent aisément le sens en se basant sur leur connaissance de la situation, leurs connaissances culturelles et leur historique conversationnel, les systèmes d'IA traditionnels se sont principalement basés sur la reconnaissance de formes et l'analyse statistique, sans véritablement « comprendre » le contexte général.

Ce décalage contextuel se manifeste de multiples façons : une IA peut ne pas reconnaître le sarcasme, passer à côté de références culturelles ou oublier des passages antérieurs d'une conversation qui fournissent un contexte crucial pour interpréter de nouvelles informations. C'est comme parler à quelqu'un qui possède un vocabulaire riche, mais qui n'a ni conscience sociale ni souvenir de ce que vous avez dit cinq minutes plus tôt.

La nature multiforme du contexte

Le contexte linguistique comprend les mots, les phrases et les paragraphes qui entourent une affirmation particulière. Lorsqu'une personne dit : « Je ne supporte pas ça », le sens change radicalement si la phrase précédente est « Cette chaise est bancale » plutôt que « Cette musique est magnifique ».

Le contexte situationnel implique de comprendre l'environnement, le moment et les circonstances dans lesquels la communication a lieu. Demander son chemin n'a pas le même sens lorsqu'on est perdu au coin d'une rue ou qu'on est assis à une conférence sur le leadership.

Le contexte culturel intègre les connaissances, les références et les normes partagées qui façonnent la communication. Lorsqu'une personne évoque « faire un Hamlet », elle fait référence à l'indécision, mais une IA sans contexte culturel pourrait se mettre à réciter du Shakespeare.

Le contexte interpersonnel comprend la dynamique relationnelle, l'histoire commune et les états émotionnels qui colorent les interactions. Les amis comprennent les blagues des autres et peuvent détecter de subtils changements de ton qui trahissent les émotions.

Pour que les systèmes d’IA puissent véritablement comprendre le contexte comme le font les humains, ils doivent saisir toutes ces dimensions simultanément – un défi monumental qui occupe les chercheurs depuis des décennies.

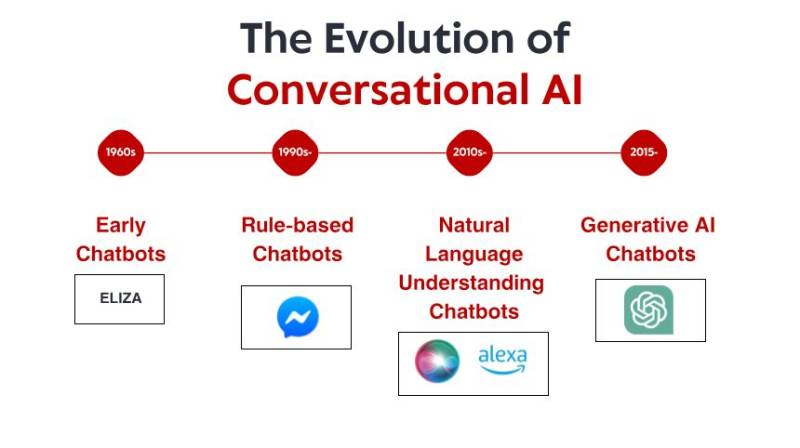

Les approches traditionnelles et leurs limites

Cette approche est rapidement devenue intenable. Le nombre de contextes potentiels est pratiquement infini, et la programmation manuelle des réponses pour chaque scénario est impossible. Ces systèmes étaient fragiles, incapables de généraliser à de nouvelles situations et tombaient souvent en panne face à des entrées inattendues.

Les méthodes statistiques comme les n-grammes et l'apprentissage automatique de base ont quelque peu amélioré la situation en permettant aux systèmes de reconnaître des schémas d'utilisation du langage. Cependant, ces approches peinaient encore à gérer les dépendances à long terme (reliant des informations mentionnées bien plus tôt dans une conversation à des déclarations actuelles) et ne pouvaient pas intégrer une connaissance globale du monde.

Même des approches de réseaux neuronaux plus sophistiquées, comme les réseaux neuronaux récurrents précoces (RNN) et les réseaux de mémoire à long terme (LSTM), ont amélioré la conscience contextuelle, mais ont toujours souffert d'une « amnésie contextuelle » lorsque les conversations devenaient longues ou complexes.

La révolution des transformateurs

Cette architecture a permis aux modèles de capturer des dépendances contextuelles beaucoup plus longues et de conserver une trace des informations mentionnées des milliers de mots auparavant. Le célèbre article « attention is all you need » de Vaswani et al. a démontré que cette approche pouvait améliorer considérablement la qualité de la traduction automatique en préservant mieux le sens contextuel entre les langues.

Cette innovation architecturale a ouvert la voie à des modèles tels que BERT, GPT et leurs successeurs, qui ont démontré des capacités de compréhension contextuelle de plus en plus sophistiquées. Ces modèles sont pré-entraînés sur de vastes corpus de textes, ce qui leur permet d'absorber des schémas d'utilisation de la langue dans d'innombrables contextes avant d'être affinés pour des applications spécifiques.

L'échelle de ces modèles a connu une croissance exponentielle, passant de millions de paramètres à des centaines de milliards, leur permettant de capturer des schémas contextuels de plus en plus subtils. Les plus grands modèles semblent désormais disposer de formes rudimentaires de connaissances de « bon sens » qui les aident à lever l’ambiguïté des références déroutantes et à comprendre le sens implicite.

Contexte multimodal : au-delà du texte

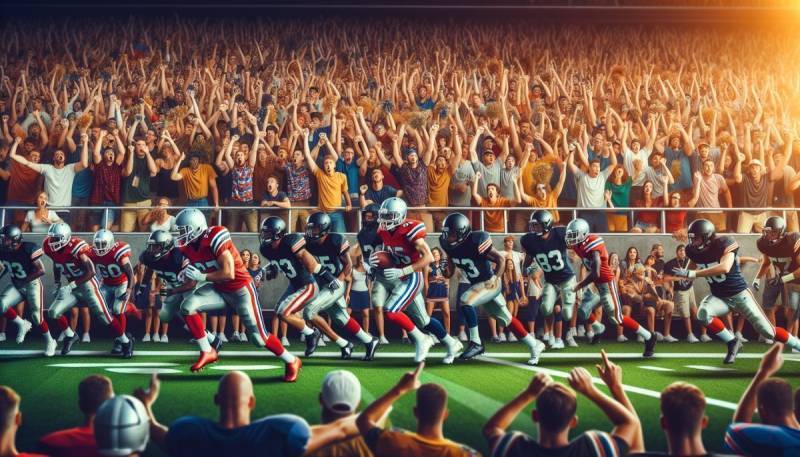

De récentes avancées en matière d'IA multimodale commencent à combler ce fossé. Des systèmes comme CLIP, DALL-E et leurs successeurs peuvent relier le langage et les informations visuelles, créant ainsi une compréhension contextuelle plus riche. Par exemple, si l'on leur présente l'image d'un stade bondé accompagnée d'un texte sur le match, ces systèmes peuvent déduire s'il s'agit de baseball, de football américain ou de soccer grâce à des indices visuels.

Les modèles audiovisuels peuvent désormais détecter les états émotionnels à partir du ton de la voix et des expressions faciales, ajoutant ainsi un niveau crucial de compréhension contextuelle. Lorsqu'une personne dit « Bravo » avec sarcasme ou sincérité, le sens change radicalement – une distinction que ces nouveaux systèmes commencent à saisir.

La prochaine étape consiste à intégrer ces capacités multimodales à l'IA conversationnelle pour créer des systèmes capables de comprendre le contexte simultanément sur différents canaux sensoriels. Imaginez un assistant IA qui reconnaît que vous cuisinez (contexte visuel), entend votre ton frustré (contexte audio), remarque que vous lisez une recette (contexte textuel) et propose une aide pertinente sans invite explicite.

Testez VOTRE Entreprise en Minutes

Créez votre compte et lancez votre chatbot IA en quelques minutes. Entièrement personnalisable, aucun codage requis - commencez à engager vos clients instantanément!

Mémoire contextuelle et raisonnement

De récentes avancées dans la génération augmentée par récupération (RAG) remédient à cette limitation en permettant aux systèmes d'IA de référencer des bases de connaissances externes et l'historique des conversations. Plutôt que de s'appuyer uniquement sur des paramètres encodés lors de l'apprentissage, ces systèmes peuvent rechercher activement des informations pertinentes en cas de besoin, un peu comme les humains consultent leur mémoire.

Les fenêtres contextuelles (la quantité de texte qu'une IA peut prendre en compte pour générer des réponses) ont considérablement augmenté, passant de quelques centaines de jetons à des centaines de milliers dans les systèmes les plus avancés. Cela permet une génération de contenu long et cohérent, et des conversations qui maintiennent la cohérence au cours des échanges prolongés.

Les progrès en matière de capacités de raisonnement sont tout aussi importants. Les systèmes modernes peuvent désormais effectuer des tâches de raisonnement en plusieurs étapes, décomposant des problèmes complexes en étapes gérables tout en préservant le contexte tout au long du processus. Par exemple, lorsqu’ils résolvent un problème mathématique, ils peuvent suivre les résultats intermédiaires et les hypothèses d’une manière qui reflète la mémoire de travail humaine.

Dimensions éthiques de l'IA contextuelle

La capacité à conserver une mémoire contextuelle entre les interactions soulève également des questions de confidentialité. Si une IA se souvient de données personnelles partagées des semaines ou des mois auparavant et les récupère de manière inattendue, les utilisateurs pourraient avoir le sentiment que leur vie privée a été violée, même s'ils les ont volontairement partagées.

Les développeurs s'efforcent de répondre à ces préoccupations grâce à des techniques telles que l'oubli contrôlé, des mécanismes de consentement explicite pour le stockage des informations personnelles et des stratégies d'atténuation des biais. L'objectif est de créer une IA qui comprenne suffisamment bien le contexte pour être utile sans devenir intrusive ou manipulatrice.

Le défi de la transparence se pose également. À mesure que la compréhension contextuelle se perfectionne, il devient de plus en plus difficile pour les utilisateurs de comprendre comment les systèmes d'IA parviennent à leurs conclusions. Les techniques permettant d'expliquer la prise de décision de l'IA dans des scénarios contextuels constituent un domaine de recherche actif.

Applications concrètes de l'IA sensible au contexte

Dans le domaine de la santé, l'IA contextualisée peut interpréter les plaintes des patients en fonction de leur historique médical, de leur mode de vie et de leur traitement actuel. Lorsqu'un patient décrit ses symptômes, le système peut poser des questions de suivi pertinentes basées sur ce contexte complet plutôt que de suivre un script générique.

Les systèmes de service client conservent désormais l'historique des conversations et les informations de compte tout au long des interactions, éliminant ainsi la frustration de devoir répéter les informations. Ils peuvent détecter les états émotionnels à partir des schémas de langage et adapter leur ton en conséquence, devenant plus formel ou empathique selon le contexte.

Les applications éducatives utilisent la conscience contextuelle pour suivre le parcours d'apprentissage des étudiants, en identifiant les lacunes et les idées fausses. Plutôt que de fournir un contenu standardisé, ces systèmes adaptent les explications en fonction des questions précédentes de l'étudiant, de ses erreurs et de sa compréhension démontrée.

L'analyse de documents juridiques et financiers bénéficie énormément de la compréhension contextuelle. L'IA moderne peut interpréter les clauses dans le contexte plus large de contrats complets, de la législation applicable et de la jurisprudence, repérant les incohérences ou les problèmes potentiels qui pourraient échapper aux examinateurs humains confrontés à une surcharge d'informations.

Les outils créatifs comme les assistants d’écriture maintiennent désormais la cohérence thématique dans les œuvres longues, suggérant un contenu qui s’aligne sur les personnages, les paramètres et les arcs narratifs établis plutôt que sur la complétion générique du texte.

L'avenir de la compréhension contextuelle en IA

Les modèles de mémoire épisodique visent à doter les systèmes d'IA d'une mémoire autobiographique humaine, la capacité de se souvenir d'événements et d'expériences spécifiques plutôt que de simples schémas statistiques. Cela permettrait des interactions beaucoup plus personnalisées, basées sur une histoire commune.

Les cadres de raisonnement causal cherchent à dépasser la reconnaissance de schémas basée sur la corrélation pour comprendre les relations de cause à effet. Cela permettrait à l'IA de raisonner sur des contrefactuels (« Que se passerait-il si… ») et de faire des prédictions plus précises dans de nouveaux contextes.

Des modèles contextuels interculturels sont en cours de développement pour comprendre comment le contexte évolue selon les différents cadres culturels, rendant les systèmes d'IA plus adaptables et moins biaisés par les normes culturelles occidentales.

La recherche sur l'IA incarnée explore comment le contexte physique – le fait d'être situé dans un environnement avec la possibilité d'interagir avec lui – modifie la compréhension contextuelle. Les robots et les agents virtuels capables de voir, de manipuler des objets et de naviguer dans des espaces développent des modèles contextuels différents de ceux des systèmes textuels.

L'objectif ultime reste la création d'une intelligence artificielle générale (IAG) dotée d'une compréhension contextuelle comparable à celle des humains – des systèmes capables d'intégrer harmonieusement toutes ces formes de contexte pour communiquer et raisonner sur le monde aussi efficacement que les humains. Bien que nous soyons encore loin de ce cap, le rythme des avancées technologiques suggère que nous avançons progressivement dans cette direction.

À mesure que ces technologies évoluent, elles transforment notre relation avec les machines, passant d'interactions rigides et basées sur des commandes à des collaborations fluides et riches en contexte, qui s'apparentent de plus en plus à une communication interhumaine. L'IA qui comprend véritablement le contexte n'est pas seulement une prouesse technique : elle représente un tournant fondamental dans le parcours technologique de l'humanité.