Testez VOTRE Entreprise en Minutes

Créez votre compte et lancez votre chatbot IA en quelques minutes. Entièrement personnalisable, aucun codage requis - commencez à engager vos clients instantanément!

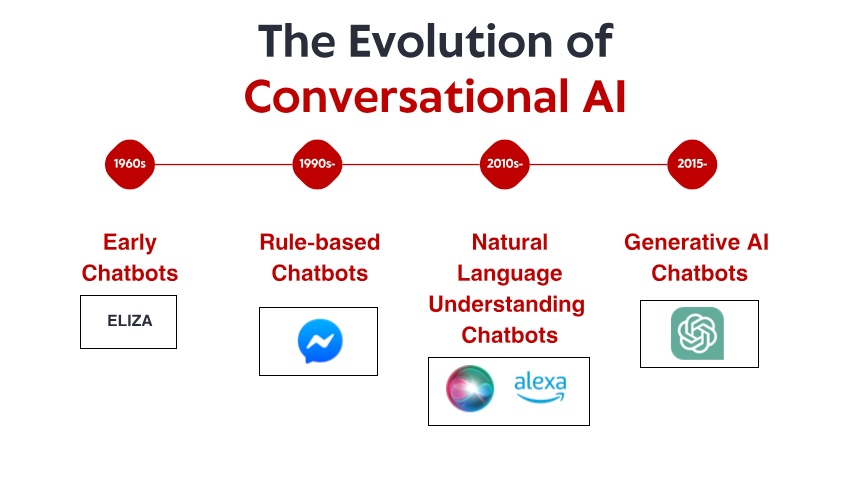

Les humbles débuts : les premiers systèmes fondés sur des règles

Ce qui rendait ELIZA remarquable n'était pas sa sophistication technique – comparé aux normes actuelles, le programme était incroyablement basique. C'était plutôt l'effet profond qu'il produisait sur les utilisateurs. Tout en sachant qu'ils s'adressaient à un programme informatique sans réelle compréhension, de nombreuses personnes ont noué des liens émotionnels avec ELIZA, partageant des pensées et des sentiments profondément personnels. Ce phénomène, que Weizenbaum lui-même trouvait troublant, révélait un aspect fondamental de la psychologie humaine et de notre propension à anthropomorphiser même les interfaces conversationnelles les plus simples.

Tout au long des années 1970 et 1980, les chatbots basés sur des règles ont suivi le modèle d'ELIZA, avec des améliorations progressives. Des programmes comme PARRY (simulant un schizophrène paranoïaque) et RACTER (auteur d'un livre intitulé « La barbe du policier est à moitié construite ») sont restés fidèles au paradigme basé sur des règles, utilisant des modèles prédéfinis, la correspondance de mots-clés et des réponses basées sur des modèles.

Ces premiers systèmes présentaient de sérieuses limitations. Ils ne pouvaient pas réellement comprendre le langage, apprendre des interactions ou s'adapter à des entrées inattendues. Leurs connaissances se limitaient aux règles explicitement définies par leurs programmeurs. Lorsque les utilisateurs s'écartaient inévitablement de ces limites, l'illusion d'intelligence volait rapidement en éclats, révélant la nature mécanique sous-jacente. Malgré ces contraintes, ces systèmes pionniers ont posé les bases sur lesquelles toute l'IA conversationnelle future allait s'appuyer.

La révolution de la connaissance : systèmes experts et information structurée

Des systèmes experts comme MYCIN (qui diagnostiquait les infections bactériennes) et DENDRAL (qui identifiait les composés chimiques) organisaient l'information dans des bases de connaissances structurées et utilisaient des moteurs d'inférence pour tirer des conclusions. Appliquée aux interfaces conversationnelles, cette approche a permis aux chatbots d'aller au-delà de la simple recherche de motifs pour s'apparenter à du raisonnement, du moins dans des domaines restreints.

Les entreprises ont commencé à mettre en œuvre des applications pratiques, comme des systèmes automatisés de service client, utilisant cette technologie. Ces systèmes utilisaient généralement des arbres de décision et des interactions basées sur des menus plutôt que des conversations libres, mais ils représentaient les premières tentatives d'automatisation d'interactions qui nécessitaient auparavant une intervention humaine.

Les limites restaient importantes. Ces systèmes étaient fragiles, incapables de gérer correctement les entrées inattendues. Ils exigeaient des efforts considérables de la part des ingénieurs du savoir pour encoder manuellement les informations et les règles. Et, plus important encore, ils ne parvenaient pas encore à comprendre pleinement le langage naturel dans toute sa complexité et son ambiguïté.

Néanmoins, cette époque a établi des concepts importants qui deviendraient plus tard cruciaux pour l'IA conversationnelle moderne : la représentation structurée des connaissances, l'inférence logique et la spécialisation par domaine. Le terrain était propice à un changement de paradigme, même si la technologie n'en était pas encore tout à fait là.

Compréhension du langage naturel : la percée de la linguistique computationnelle

Cette évolution a été rendue possible par plusieurs facteurs : l’augmentation de la puissance de calcul, l’amélioration des algorithmes et, surtout, la disponibilité de vastes corpus de textes permettant d’identifier des schémas linguistiques. Les systèmes ont commencé à intégrer des techniques telles que :

Étiquetage des parties du discours : identification des fonctions des mots comme noms, verbes, adjectifs, etc.

Reconnaissance d’entités nommées : détection et classification des noms propres (personnes, organisations, lieux).

Analyse des sentiments : détermination de la tonalité émotionnelle d’un texte.

Analyse syntaxique : analyse de la structure des phrases pour identifier les relations grammaticales entre les mots.

Une avancée notable a été réalisée avec Watson d’IBM, qui a battu des champions humains au jeu télévisé Jeopardy ! En 2011, Watson, bien qu'il ne s'agisse pas d'un système conversationnel à proprement parler, a démontré des capacités sans précédent à comprendre des questions en langage naturel, à effectuer des recherches dans de vastes bases de connaissances et à formuler des réponses – des capacités qui se révéleront essentielles pour la prochaine génération de chatbots.

Des applications commerciales ont rapidement suivi. Siri d'Apple a été lancé en 2011, offrant des interfaces conversationnelles au grand public. Bien que limité par rapport aux normes actuelles, Siri a représenté une avancée significative pour rendre les assistants IA accessibles aux utilisateurs ordinaires. Cortana de Microsoft, Assistant de Google et Alexa d'Amazon ont suivi, chacun repoussant les limites de l'IA conversationnelle destinée aux consommateurs.

Malgré ces avancées, les systèmes de cette époque peinaient encore à gérer le contexte, le raisonnement logique et à générer des réponses véritablement naturelles. Ils étaient plus sophistiqués que leurs ancêtres basés sur des règles, mais restaient fondamentalement limités dans leur compréhension du langage et du monde.

Apprentissage automatique et approche axée sur les données

Cette époque a vu l'essor de la classification des intentions et de l'extraction d'entités comme composants essentiels de l'architecture conversationnelle. Lorsqu'un utilisateur formulait une requête, le système :

Classait l'intention globale (par exemple, réserver un vol, consulter la météo, écouter de la musique)

Extrayait les entités pertinentes (par exemple, lieux, dates, titres de chansons)

Mettait ces entités en correspondance avec des actions ou des réponses spécifiques

Le lancement de la plateforme Messenger par Facebook (aujourd'hui Meta) en 2016 a permis aux développeurs de créer des chatbots capables de toucher des millions d'utilisateurs, suscitant un vif intérêt commercial. De nombreuses entreprises se sont empressées de déployer des chatbots, mais les résultats ont été mitigés. Les premières implémentations commerciales ont souvent frustré les utilisateurs, avec une compréhension limitée et des flux de conversation rigides.

L'architecture technique des systèmes conversationnels a également évolué au cours de cette période. L'approche classique impliquait un pipeline de composants spécialisés :

Reconnaissance vocale automatique (pour les interfaces vocales)

Compréhension du langage naturel

Gestion des dialogues

Génération du langage naturel

Synthèse vocale (pour les interfaces vocales)

Chaque composant pouvait être optimisé séparément, permettant des améliorations progressives. Cependant, ces architectures de pipeline souffraient parfois de propagation d'erreurs : les erreurs initiales se répercutaient sur l'ensemble du système.

Si l'apprentissage automatique a considérablement amélioré les capacités, les systèmes peinaient encore à maintenir le contexte lors de longues conversations, à comprendre les informations implicites et à générer des réponses véritablement diversifiées et naturelles. La prochaine avancée nécessiterait une approche plus radicale.

La révolution des transformateurs : modèles de langage neuronal

Cette innovation a permis le développement de modèles linguistiques de plus en plus performants. En 2018, Google a lancé BERT (Bidirectional Encoder Representations from Transformers), qui a considérablement amélioré les performances de diverses tâches de compréhension du langage. En 2019, OpenAI a lancé GPT-2, démontrant des capacités sans précédent dans la génération de textes cohérents et contextuellement pertinents.

L'avancée la plus spectaculaire a eu lieu en 2020 avec GPT-3, qui a atteint 175 milliards de paramètres (contre 1,5 milliard pour GPT-2). Cette augmentation massive de l'échelle, combinée à des améliorations architecturales, a produit des capacités qualitativement différentes. GPT-3 pouvait générer un texte remarquablement proche de l'humain, comprendre le contexte de milliers de mots et même effectuer des tâches pour lesquelles il n'avait pas été explicitement entraîné.

En matière d'IA conversationnelle, ces avancées se sont traduites par des chatbots capables de :

Maintenir des conversations cohérentes sur plusieurs tours ;

Comprendre des requêtes nuancées sans entraînement explicite ;

Générer des réponses diversifiées et contextuellement adaptées ;

Adapter leur ton et leur style à l'utilisateur ;

Gérer les ambiguïtés et clarifier si nécessaire.

La sortie de ChatGPT fin 2022 a généralisé ces fonctionnalités, attirant plus d'un million d'utilisateurs en quelques jours seulement. Soudain, le grand public a eu accès à une IA conversationnelle qui semblait qualitativement différente de tout ce qui existait auparavant : plus flexible, plus compétente et plus naturelle dans ses interactions.

Les implémentations commerciales ont rapidement suivi, les entreprises intégrant de vastes modèles linguistiques à leurs plateformes de service client, leurs outils de création de contenu et leurs applications de productivité. Cette adoption rapide reflétait à la fois l'avancée technologique et l'interface intuitive offerte par ces modèles ; la conversation est, après tout, le moyen le plus naturel pour les humains de communiquer.

Testez VOTRE Entreprise en Minutes

Créez votre compte et lancez votre chatbot IA en quelques minutes. Entièrement personnalisable, aucun codage requis - commencez à engager vos clients instantanément!

Capacités multimodales : au-delà des conversations textuelles

Des modèles de langage visuel comme DALL-E, Midjourney et Stable Diffusion ont démontré leur capacité à générer des images à partir de descriptions textuelles, tandis que des modèles comme GPT-4, dotés de capacités visuelles, pouvaient analyser des images et en discuter intelligemment. Cela a ouvert de nouvelles perspectives pour les interfaces conversationnelles :

Des robots de service client capables d'analyser des photos de produits endommagés

Des assistants commerciaux capables d'identifier des articles à partir d'images et de trouver des produits similaires

Des outils pédagogiques capables d'expliquer des schémas et des concepts visuels

Des fonctionnalités d'accessibilité permettant de décrire des images pour les utilisateurs malvoyants

Les capacités vocales ont également connu des progrès considérables. Les premières interfaces vocales, comme les systèmes de réponse vocale interactive (SVI), étaient notoirement frustrantes, limitées à des commandes et des structures de menu rigides. Les assistants vocaux modernes peuvent comprendre les schémas vocaux naturels, prendre en compte les différents accents et troubles de la parole, et répondre avec des voix synthétisées de plus en plus naturelles.

La fusion de ces capacités crée une IA conversationnelle véritablement multimodale, capable de basculer facilement entre différents modes de communication en fonction du contexte et des besoins de l'utilisateur. Un utilisateur peut commencer par une question écrite sur la réparation de son imprimante, envoyer une photo du message d'erreur, recevoir un schéma mettant en évidence les boutons concernés, puis passer aux instructions vocales pendant que ses mains sont occupées à la réparation.

Cette approche multimodale représente non seulement une avancée technique, mais aussi une évolution fondamentale vers une interaction homme-machine plus naturelle : elle permet de rencontrer les utilisateurs selon le mode de communication le plus adapté à leur contexte et à leurs besoins.

Génération augmentée par récupération : ancrer l'IA dans les faits

La génération augmentée par récupération (RAG) est apparue comme une solution à ces défis. Plutôt que de s'appuyer uniquement sur les paramètres appris pendant l'entraînement, les systèmes RAG combinent les capacités génératives des modèles linguistiques avec des mécanismes de récupération permettant d'accéder à des sources de connaissances externes.

L'architecture RAG classique fonctionne comme suit :

Le système reçoit une requête utilisateur.

Il recherche les informations pertinentes dans les bases de connaissances.

Il alimente le modèle de langage à la fois avec la requête et les informations récupérées.

Le modèle génère une réponse basée sur les faits récupérés.

Cette approche offre plusieurs avantages :

Des réponses plus précises et factuelles grâce à des informations vérifiées.

La possibilité d'accéder à des informations actualisées au-delà du seuil d'apprentissage du modèle.

Des connaissances spécialisées issues de sources spécifiques au domaine, comme la documentation de l'entreprise.

La transparence et l'attribution grâce à la citation des sources d'information.

Pour les entreprises qui mettent en œuvre l'IA conversationnelle, le RAG s'est avéré particulièrement utile pour les applications de service client. Un chatbot bancaire, par exemple, peut accéder aux derniers documents de politique, informations de compte et enregistrements de transactions afin de fournir des réponses précises et personnalisées, ce qui serait impossible avec un modèle de langage autonome.

L'évolution des systèmes RAG se poursuit avec des améliorations de la précision de la récupération, des méthodes plus sophistiquées d'intégration des informations récupérées au texte généré et de meilleurs mécanismes d'évaluation de la fiabilité des différentes sources d'information.

Le modèle de collaboration homme-IA : trouver le juste équilibre

Les implémentations les plus réussies aujourd'hui suivent un modèle collaboratif où :

L'IA gère les requêtes courantes et répétitives qui ne nécessitent pas de jugement humain ;

Les humains se concentrent sur les cas complexes nécessitant empathie, raisonnement éthique ou résolution créative de problèmes ;

Le système connaît ses limites et transmet en douceur les informations aux agents humains lorsque cela est nécessaire ;

La transition entre l'IA et l'assistance humaine est transparente pour l'utilisateur ;

Les agents humains disposent d'un historique complet des conversations avec l'IA ;

L'IA continue d'apprendre des interventions humaines, élargissant progressivement ses capacités.

Cette approche reconnaît que l'IA conversationnelle ne doit pas viser à remplacer complètement l'interaction humaine, mais plutôt à la compléter, en gérant les requêtes simples et volumineuses qui consomment du temps des agents humains, tout en garantissant que les problèmes complexes relèvent de l'expertise humaine appropriée.

La mise en œuvre de ce modèle varie selon les secteurs. Dans le secteur de la santé, les chatbots IA peuvent gérer la prise de rendez-vous et le dépistage des symptômes de base, tout en garantissant que les conseils médicaux proviennent de professionnels qualifiés. Dans le secteur juridique, l'IA peut faciliter la préparation et la recherche de documents, laissant l'interprétation et la stratégie aux avocats. Dans le service client, l'IA peut résoudre des problèmes courants tout en transmettant les problèmes complexes à des agents spécialisés.

À mesure que les capacités de l'IA progressent, la frontière entre ce qui nécessite une intervention humaine et ce qui peut être automatisé se déplacera, mais le principe fondamental demeure : une IA conversationnelle efficace doit renforcer les capacités humaines plutôt que simplement les remplacer.

Le paysage futur : où se dirige l'IA conversationnelle

Personnalisation à grande échelle : Les systèmes du futur adapteront de plus en plus leurs réponses non seulement au contexte immédiat, mais aussi au style de communication, aux préférences, au niveau de connaissances et à l'historique relationnel de chaque utilisateur. Cette personnalisation rendra les interactions plus naturelles et pertinentes, même si elle soulève d'importantes questions concernant la confidentialité et l'utilisation des données.

Intelligence émotionnelle : Alors que les systèmes actuels peuvent détecter les sentiments fondamentaux, l'IA conversationnelle du futur développera une intelligence émotionnelle plus sophistiquée : elle reconnaîtra les états émotionnels subtils, réagira de manière appropriée à la détresse ou à la frustration, et adaptera son ton et son approche en conséquence. Cette capacité sera particulièrement précieuse pour les applications de service client, de santé et d'éducation.

Assistance proactive : Plutôt que d'attendre des demandes explicites, les systèmes conversationnels de nouvelle génération anticiperont les besoins en fonction du contexte, de l'historique utilisateur et des signaux environnementaux. Un système pourrait remarquer que vous planifiez plusieurs réunions dans une ville inconnue et vous proposer proactivement des options de transport ou des prévisions météorologiques. Intégration multimodale fluide : Les systèmes du futur dépasseront la simple prise en charge de différentes modalités pour les intégrer harmonieusement. Une conversation pourra s'effectuer naturellement entre texte, voix, images et éléments interactifs, choisissant la modalité adaptée à chaque information sans nécessiter de sélection explicite de la part de l'utilisateur.

Experts spécialisés : Si les assistants polyvalents continueront de s'améliorer, nous assisterons également à l'essor d'IA conversationnelle hautement spécialisée, dotées d'une expertise approfondie dans des domaines spécifiques : assistants juridiques maîtrisant la jurisprudence et les précédents, systèmes médicaux maîtrisant parfaitement les interactions médicamenteuses et les protocoles de traitement, ou conseillers financiers rompus aux codes fiscaux et aux stratégies d'investissement.

Apprentissage véritablement continu : Les systèmes du futur dépasseront la simple formation périodique pour évoluer vers un apprentissage continu à partir des interactions, devenant ainsi plus utiles et personnalisés au fil du temps, tout en préservant les garanties de confidentialité appropriées.

Malgré ces perspectives prometteuses, des défis subsistent. Les préoccupations en matière de confidentialité, la réduction des biais, une transparence adéquate et la mise en place d'un niveau adéquat de supervision humaine sont des enjeux permanents qui façonneront à la fois la technologie et sa réglementation. Les implémentations les plus réussies seront celles qui relèveront ces défis de manière réfléchie tout en offrant une réelle valeur ajoutée aux utilisateurs.

Il est clair que l'IA conversationnelle est passée d'une technologie de niche à un paradigme d'interface grand public qui va de plus en plus moduler nos interactions avec les systèmes numériques. L'évolution depuis la simple correspondance de motifs d'ELIZA jusqu'aux modèles linguistiques sophistiqués d'aujourd'hui représente l'une des avancées les plus significatives de l'interaction homme-machine – et le chemin est loin d'être terminé.