Testez l'IA sur VOTRE site web en 60 secondes

Voyez comment notre IA analyse instantanément votre site web et crée un chatbot personnalisé - sans inscription. Entrez simplement votre URL et regardez-la fonctionner !

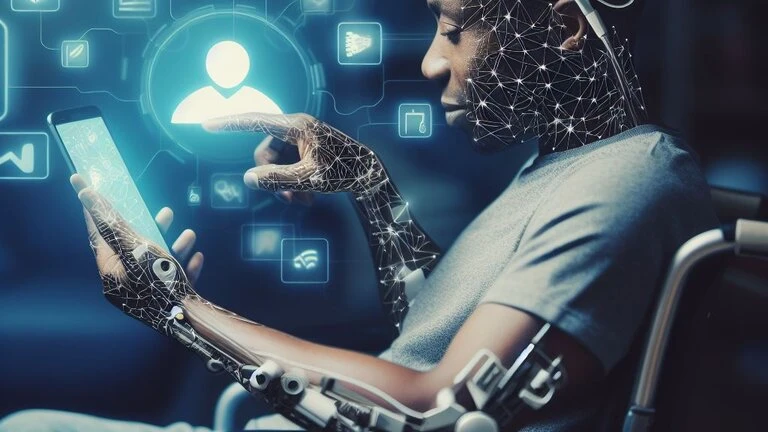

1. Introduction : L'essor de l'IA et l'expansion de ses frontières

Mais où fixer la limite ? À mesure que l'IA gagne en autonomie, les implications éthiques, juridiques et sociétales se multiplient. Ce blog explore les limites de l'IA, ses risques et comment concilier innovation et responsabilité éthique.

2. Les capacités de l’IA : où en sommes-nous ?

1. L'IA dans l'automatisation et la prise de décision

Les systèmes basés sur l'IA automatisent le service client, les processus RH et les transactions financières.

L'analyse prédictive aide les entreprises à anticiper les tendances et à optimiser leurs opérations.

Les algorithmes d'IA prennent des décisions en temps réel dans les domaines de la santé, de la cybersécurité et de la bourse.

2. IA générative et créativité

L'IA crée des œuvres d'art, de la musique et du contenu écrit, brouillant ainsi les frontières entre créativité humaine et machine.

Les outils de conception basés sur l'IA génèrent des logos, du contenu marketing et même des scénarios de films.

Les modèles d'IA contribuent à la recherche scientifique, à l'écriture de code et à l'innovation.

3. L'IA dans les systèmes autonomes

Les véhicules autonomes utilisent l'IA pour la navigation en temps réel et la détection d'objets.

Les robots basés sur l'IA sont déployés dans l'industrie manufacturière, l'exploration spatiale et les applications militaires.

Les drones et les systèmes de surveillance pilotés par l’IA surveillent les opérations de sécurité et de logistique.

3. Les limites éthiques de l’IA : où tracer la ligne ?

1. IA et suppression d'emplois : quand l'automatisation va-t-elle trop loin ?

L'IA remplace des emplois dans le service client, l'industrie manufacturière et l'analyse de données.

Si l'IA améliore l'efficacité, l'automatisation de masse pourrait entraîner des inégalités économiques et des pertes d'emplois.

Les gouvernements et les entreprises doivent investir dans des programmes de requalification en IA afin d'équilibrer automatisation et opportunités d'emploi.

2. Biais et équité de l'IA : l'IA peut-elle prendre des décisions impartiales ?

Les systèmes d'IA peuvent hériter de biais issus des données d'entraînement, ce qui entraîne des résultats injustes.

L'IA biaisée a eu un impact sur les décisions d'embauche, les algorithmes de justice pénale et les approbations de prêts.

Les cadres éthiques de l'IA doivent garantir l'équité, la responsabilité et la réduction des biais dans les modèles d'IA.

3. L'IA dans la surveillance et la confidentialité : quand est-ce trop ?

Les outils de surveillance basés sur l'IA suivent les individus, analysent les comportements et prédisent les schémas de criminalité.

L'IA de reconnaissance faciale est utilisée par les gouvernements pour le maintien de l'ordre et la surveillance de la sécurité.

La frontière entre sécurité et vie privée doit être clairement définie par une gouvernance et une réglementation strictes en matière d'IA.

4. L'IA dans la guerre et les armes autonomes

Les systèmes d'IA militaires peuvent identifier et cibler les menaces de manière autonome.

L'utilisation de l'IA dans la guerre soulève des questions morales quant à la responsabilité et à l'escalade involontaire.

Les accords internationaux doivent réglementer le déploiement de l'IA dans les applications militaires.

5. L'IA et la manipulation des deepfakes

Les deepfakes générés par l'IA peuvent diffuser de fausses informations, usurper l'identité de personnes et manipuler l'opinion publique.

La manipulation des médias par l'IA menace les institutions démocratiques et la réputation personnelle.

Les gouvernements doivent introduire une réglementation stricte sur les contenus générés par l'IA afin de lutter contre l'utilisation abusive des deepfakes.

4. Les limites légales et réglementaires de l'IA

1. Réglementation et gouvernance mondiales de l'IA

La loi européenne sur l'IA vise à réglementer l'utilisation de l'IA en fonction des catégories de risque.

La charte américaine des droits de l'IA définit les principes éthiques de développement de l'IA.

Les pays introduisent des lois sur la confidentialité des données (RGPD, CCPA) pour réguler l'accès de l'IA aux données personnelles.

2. Éthique de l'IA et responsabilité d'entreprise

Des entreprises comme Google, Microsoft et OpenAI élaborent des politiques internes d'éthique de l'IA.

La transparence de l'IA est essentielle pour garantir la responsabilité et prévenir les applications d'IA nuisibles.

Les entreprises doivent mettre en place des équipes de gouvernance de l'IA pour superviser la mise en œuvre éthique de l'IA.

3. Définir le rôle de l'IA dans la société

L'IA devrait-elle être autorisée à prendre des décisions qui changent la vie dans les domaines de la santé, de la finance et de la justice pénale ?

Quel degré de contrôle humain devrait-il avoir sur la prise de décision et l'autonomie de l'IA ?

Des politiques claires doivent définir les domaines où l'IA doit être utile et ceux où une surveillance humaine est requise.

5. Trouver un équilibre : comment garantir un développement responsable de l’IA

1. Conception éthique et explicabilité de l'IA

Les développeurs d'IA doivent privilégier l'IA explicable (XAI) afin de garantir la transparence des décisions en la matière.

Les principes éthiques de l'IA doivent inclure la responsabilité, l'équité et la non-discrimination.

2. Collaboration homme-IA plutôt qu'automatisation complète

L'IA doit renforcer les capacités humaines plutôt que de remplacer entièrement les travailleurs humains.

Les entreprises doivent mettre en œuvre l'IA comme un outil collaboratif, garantissant la supervision humaine des décisions critiques.

3. Réglementation stricte de l'IA et coopération mondiale

Les gouvernements doivent adopter des lois qui empêchent l'utilisation abusive de l'IA tout en favorisant l'innovation.

La recherche sur la sécurité de l'IA doit être financée afin d'explorer les risques à long terme et les stratégies d'atténuation.

4. Formation à l'IA et adaptation des effectifs

Les programmes de formation et de reconversion axés sur l'IA doivent préparer les travailleurs à des carrières enrichies par l'IA.

Les entreprises doivent investir dans la formation à l'IA et à l'éthique pour leurs employés et leurs parties prenantes.

6. Conclusion : L’avenir de l’IA et les limites éthiques

L'avenir de l'IA dépend de la limite que nous fixons : trouver un équilibre entre innovation et éthique, automatisation et emploi, sécurité et confidentialité. La clé réside dans un développement responsable de l'IA qui privilégie le bien-être humain, l'équité et la durabilité à long terme.

À mesure que l'IA évolue, la question fondamentale demeure : comment garantir qu'elle serve l'humanité sans dépasser les limites éthiques et sociétales ?